五角大楼AI伦理准则能否阻止机器人毁灭人类?

随着人工智能技术的迅猛发展,有关机器人可能威胁人类生存的讨论日益激烈。五角大楼为此制定了五条人工智能伦理准则:负责任、可追溯、可靠、可治理、可控。这些准则旨在确保军事领域AI系统的安全性与可控性。

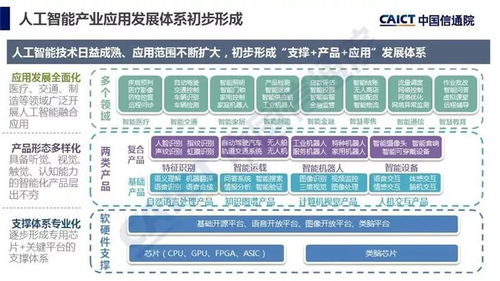

在人工智能应用软件开发过程中,这些准则要求系统必须明确责任归属,开发过程全程可追溯,确保算法决策的可靠性,建立有效的监管机制,并保留人类对关键决策的最终控制权。从技术角度看,这涉及多层次的防护设计:在软件架构层面嵌入伦理约束,通过测试验证系统行为的可预测性,以及设置人工否决机制。

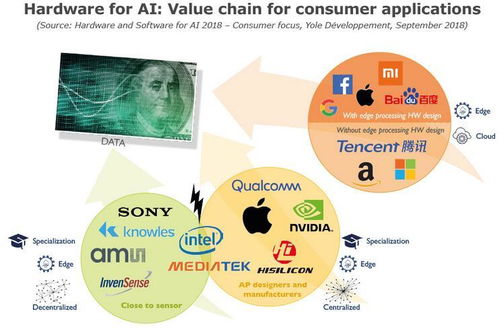

这些准则的实际效力面临挑战。AI系统的复杂性可能导致不可预见的涌现行为;各国在AI军事化应用上存在竞争,可能削弱伦理约束;民用AI技术的扩散增加了监管难度。专家指出,真正有效的防护需要全球协作、持续的技术迭代和健全的法律体系共同作用。

当前,在自动驾驶、医疗诊断等民用领域,类似的伦理准则已产生积极影响。但在应对极端假设的‘机器人毁灭人类’场景时,现有措施仍显不足。未来需要更先进的价值对齐技术、更强大的安全验证体系,以及跨学科的风险评估机制,才能构建真正可靠的人工智能防护网。

如若转载,请注明出处:http://www.kloiyy.com/product/26.html

更新时间:2026-03-03 05:36:04